为什么更新内容后排名反而下降?4个可能原因和解决方法!

光算科技

光算科技 - 专业谷歌SEO,外贸独立站建站,外贸网站排名优化推广

扫码关注公众号

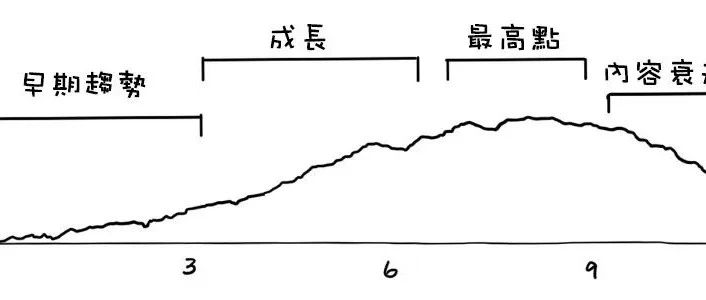

根据不少SEO工具商和行业观察,约有近30% 的网站在进行主要的内容更新后会经历这种 “阵痛期”,核心关键词排名平均可能下滑 5-10个位置 的情况并不少见。

看到排名下降当然很着急,但这其实往往是谷歌在 重新评估 你的页面。

可能是内容调整时 无意偏离了用户真正想找的信息(比如搜索意图没抓准),或者刚好碰上谷歌 算法更新 带来的波动。

接下来,我们就具体分析这 4个最常见、也最需要优先排查的原因

技术问题或配置错误,影响了正常抓取和索引

根据一些SEO服务商汇总的大规模匿名站点数据,在因更新导致排名下降的案例中,超过35%最终可以追溯到技术或配置错误。

更让人警觉的是, Google Search Console (GSC) 后台数据显示, 超过25%的网站 在其覆盖范围报告中长期存在因技术错误导致的索引问题。

索引被莫名“主动屏蔽”:告诉谷歌“别收我!”

真实场景:

- 内容管理系统(CMS)插件/主题更新后的陷阱:

更新了WordPress主题?或是修改了网站框架(如React/Vue渲染逻辑)?某些插件或主题设置可能默认或在更新过程中,悄悄给页面添加了 <meta name="robots" content="noindex">标签。这等于在你精心装修的新店门口挂了个“暂停营业”的牌子给谷歌看。 - 临时处理忘了撤:

原本用 noindex让谷歌临时别收录某个测试页面或旧版本,更新正式内容时忘了移除这个标签。 robots.txt配置失误:全局或目录级的 robots.txt文件中,一个Disallow: /(禁止所有爬虫)或者Disallow: /important-updated-page/(禁止特定更新目录)写错了路径,导致整个更新区域无法被爬取。据统计,GSC覆盖率报告中,因robots.txt文件阻止导致无法索引的问题占比高达15%。- XML站点地图错误:

更新内容后没提交新站点地图,或者新站点地图里忘了包含这些重要更新页面,或者站点地图本身格式错误、包含死链接。谷歌可能会慢一步甚至错过这些更新。

如何精准排查(手把手):

- GSC是侦探主武器:

直奔主题。打开你的Google Search Console: - “索引” > “覆盖范围”报告:

重点看“已排除”标签页。仔细过滤“被 noindex标记排除”和“被robots.txt屏蔽”的页面。超过25%的网站在这里能找到自己没意识到的索引问题。 找到你的更新页面了吗? - “网址检查”工具:

直接输入你更新的页面URL。核心看三点:“索引状态”是否为“已编入索引”?是否显示“被 noindex标记阻止”?是否显示“robots.txt禁止抓取”?这是最直接的诊断报告。 - 查看页面HTML源代码:

在浏览器里打开你更新后的页面,按 Ctrl+U(Windows)或Cmd+Option+U(Mac)看源代码。搜索<meta name="robots"或noindex,看是否存在content="noindex"。 - 检查

robots.txt:浏览器访问 yoursite.com/robots.txt,读文件内容。确认是否有Disallow:规则意外影响了你的更新页面路径?用小工具在线测试它的语法规则。 - 确认站点地图提交与内容:

在GSC “索引” > “站点地图” 里查看提交状态。下载你提交的Sitemap文件,打开核对是否包含了更新后的页面URL?用XML验证器查看结构是否正确。

URL变更与301重定向问题

真实痛点:

- 改了URL没做重定向:

最直接致命!比如把 /old-page/改成/new-page/,却没设置任何跳转。用户点旧链接直接404(页面不存在)。谷歌爬虫遇到死胡同,旧页面的排名权重瞬间归零,新页面可能还没被爬取和建立权重。 - 301重定向设置错误:

- 链式重定向:

/old-page/->/temp-page/->/new-page/。每次跳转会损耗部分链接“权重”,效率低还易出错。 - 重定向到错误目标:

不小心定向到不相关的页面。 - 漏掉带参数的URL:

旧页面可能有多个版本如 /old-page/?source=facebook,如果只重定向了/old-page/,那些带参数的链接依然404。 - 重定向无效或返回错误码:

服务器配置不当,导致重定向返回 302(临时)、404甚至500错误。 - 外部链接“资产”蒸发:

指向你旧页面的所有优质外链,因为错误的跳转而无法把“权重投票”有效传递给新页面。相当于扔掉了一笔宝贵的SEO遗产。研究发现,有效的301重定向能将旧页面90%以上的链接权重传递给新页面,而错误或缺失的301则会让这个价值大打折扣甚至为零。

如何精准排查:

- 模拟访问“所有”旧地址:

找到之前有排名的旧页面URL(用GSC“效果报告”查看历史数据或回忆)。在浏览器无痕窗口手动访问它: 是否瞬间(状态码301或308)跳到了 正确 的新地址? 还是显示404错误? 或者被跳到了一个错误的、无关的页面? - 检查链接权重转移(外链审计):

使用链接分析工具(如Ahrefs, SEMrush免费版也够用)查看旧页面的外链。 点进几个重要外链来源网站,看它们链向的是你的旧URL吗? 访问那个旧URL,确认它是否通过301/308跳到了新页面?工具是否显示新页面继承了(部分)旧页面的链接权重? - 利用GSC的“效果报告”对比:

对比更新前后的时间段,看旧页面URL和新页面URL的展现量、点击量变化。旧页面是否急速衰减为0?新页面是否承接了流量?承接效果差就可能是重定向问题。 - 服务器日志分析(进阶):

查看服务器日志中针对旧URL的访问请求,看看谷歌爬虫访问时得到的是什么HTTP状态码?是301、404还是其他?

服务器错误与页面性能退化

更新后暴露的性能问题:

- 服务器端突发错误:

更新后服务器负载剧增、代码冲突或配置错误,导致爬虫访问你更新页面时频繁遇到: 5xx服务器错误(特别是 503 Service Unavailable:服务器临时过载或维护)4xx客户端错误(例如 403 Forbidden:权限问题)- 短暂但频繁的不可用会导致谷歌降低抓取频率甚至临时忽略页面。

- 页面加载速度显著变慢(特别是移动端):

新加入的臃肿插件/脚本、未优化的超大图片、复杂的渲染逻辑都会拖慢加载。 - 谷歌页面速度指标(如LCP, FID, CLS)变差:

Core Web Vitals是谷歌明确的排名因素。数据显示,当移动端页面加载时间从1秒增加到3秒,跳出率会提高32%。谷歌爬虫虽不会“跳”,但它会记录加载效率,速度慢的页面抓取预算更少,影响权重评估。 - 资源加载失败(阻塞渲染):

新引用的JavaScript、CSS字体文件加载超时或失败,导致页面“崩了”或渲染不完整,谷歌只能获取到残缺内容。

如何精准排查:

- GSC警报与检查工具:

- “覆盖范围”报告:

看是否有页面因服务器错误(5xx)或访问被拒(4xx)被排除索引。 - “网址检查”工具:

直接测试你的更新页面。报告会明确告诉你抓取时是否遇到错误(状态码),以及抓取呈现的HTML(看看谷歌实际看到的和浏览器看到的是否一样?是否缺了关键内容?)。 - 速度测试必不可少:

- Google PageSpeed Insights:

输入你的更新页面URL。重点关注移动端分数和诊断报告。 它会标出具体的拖慢因素(大图、阻塞渲染的JS/CSS、服务器响应慢等)。对比更新前后的报告差异。 - Web.dev Measure 或 Lighthouse (Chrome DevTools):

同样提供详细的速度诊断。 - 移动设备友好性测试:

GSC有专门的测试工具。更新后页面在模拟手机环境下的布局和功能都正常吗?

更新后适配性问题恶化

- 真实陷阱:

关键内容被隐藏(如通过CSS display: none)。布局混乱(文字重叠、图片溢出、按钮点不到)。 加载了过多的、非必要的移动端资源。 - 无视“移动优先索引”:

谷歌早已主要基于移动版本内容进行索引和排名。更新桌面版内容时,若同步修改了响应式布局的逻辑,导致移动版页面: - 插件/组件兼容性问题:

在移动视图下,新加入的轮播图、表单、交互按钮可能无法正常显示或工作。 - 触控体验变差:

按钮太小、间距太密,容易误点。 - 如何精准排查:

- 谷歌官方移动设备友好测试工具 (Google Mobile-Friendly Test):

输入URL测试。报告会告诉你问题在哪(文本太小?视口没设置好?链接点不了?)。 - 真实设备测试:

用你的手机和平板(不同尺寸)去打开更新后的页面,手动浏览和交互。这是最直接的体验。 - 查看GSC的“移动设备可用性”报告:

看你的更新页面是否有新增的移动可用性问题。 - 核心网页指标(特别是CLS - 累积布局偏移):

PageSpeed Insights会报告移动版CLS值。过高的CLS意味着用户在浏览时页面元素频繁跳动,体验极差。谷歌要求 CLS < 0.1 才能达到“良好”标准。 更新后CLS恶化了?

发现技术问题后怎么做?

根据上述方法精准定位具体问题(是noindex?robots.txt?还是301设错了?还是服务器崩溃?)

修复问题: 移除错误的标签、修正robots.txt、正确设置301重定向、优化代码/图片/服务器解决速度问题、修复移动端布局等。

通过GSC工具明确告知谷歌:

修复索引问题后,在“网址检查”工具里对页面请求“验证”或“请求重新索引”。 更新robots.txt或解决服务器错误后,等待谷歌重新抓取(可能需要几天)。 提交更新后的站点地图。

耐心等待重新抓取和评估: 修复后谷歌需要时间重新访问页面、处理新信息、重新评估排名。通常几天到几周内能看到积极变化(取决于问题严重性和网站权重)。

更新后的内容质量下降或偏离用户搜索意图

内容更新了,技术上也查过都没毛病,但排名还是往下掉?这时候就得好好审视你更新的内容本身了。

不是说改了就一定更好,有时反而可能“改坏”了。

别不服气,Ahrefs对大量更新案例的分析指出,约40%的网站更新后排名下降直接关联内容质量问题或搜索意图不匹配。

谷歌评判排名的核心,永远是谁能最好地满足用户搜索背后的真实需求

重新锁定“用户搜索意图”

为什么会跑偏?

- “我觉得用户需要这个!”:

最大的陷阱!更新时,往往依据个人经验或公司内部目标,而非用户的实际搜索数据和反馈。你以为讲清楚原理很重要,用户其实只想看5分钟修好水龙头的步骤。 - 忽略SERPs(搜索结果页)的“信号灯”:

更新前没认真分析目标关键词下谷歌排名前10的页面长啥样?它们都在解决什么问题?类型是信息资讯(Blog Post)、操作指南(How-to Guide)、产品对比(Comparison)、还是购买/下载页面(Transactional)?根据 Ahrefs 对200万个关键词的研究,满足特定搜索意图的内容排名前3的几率比其他内容高出3倍。 - 关键词理解太表面:

只看核心关键词字面意思,没深挖长尾词及其代表的深层问题。比如搜“最佳跑步鞋”,用户意图可能是“第一双跑鞋推荐”(新手)、“适合大体重减脂的跑鞋”(特定需求)、“专业马拉松竞速鞋”(专业人士)。意图不同,内容方向天差地别。

如何精准“校准”意图?

- SERP深度侦察:

把你的核心目标关键词(比如你更新的页面想优化的词)一个个输入谷歌搜索(最好用无痕模式)。 - 看排名靠前的都是什么类型页面?

列表(Listicles)?问答(Q&A)?长篇指南(Ultimate Guide)?视频占据首位?这直接告诉你谷歌认为哪种内容最能满足意图。 - “People also ask”(用户还问)和“Related searches”(相关搜索)是金矿!

这些是用户真实需求的延伸。你的内容覆盖了这些问题吗? - 细读排名靠前的摘要(Snippet)和标题:

它们普遍在强调哪些核心信息和关键词?这是谷歌提炼的“意图精华”。 - GSC搜索查询报告是金钥匙:

找到你更新页面(及其旧版本)在GSC“效果报告”中带来的真实搜索词。 用户过去用什么词找到这个页面的?排名靠前的搜索词反映了当时内容匹配了什么意图。 更新后,这些搜索词的排名和点击率有没有显著变化?下降很可能是新内容不再匹配这些词的意图了。 - 有没有新的、相关的搜索词出现在报告中?

或许你的更新无意中迎合了新的、但并非你目标的意图。 - 分析用户停留与跳出(GA4):

对比更新前后,目标页面的平均停留时间和跳出率变化。如果跳出率飙升10%以上,停留时间锐减,强烈暗示用户没找到想要的东西。 细分看来源自不同核心搜索词的流量表现差异,找到哪些词带来的用户最不满(即意图最不匹配)。

哪些价值被你改没了?

常见“劣化”操作:

- 删掉旧内容里高价值的“独门信息”:

比如独有的案例研究数据、某位专家的深度点评、一个特别实用的工具推荐或免费模板下载链接。这些往往是用户分享和留下好评的关键。 - 稀释核心关键词相关性:

为了追求内容覆盖面更广或加入新主题,硬塞进大量相关度较低的周边信息,导致核心主题的权重被摊薄。内容更新后,Semrush关键词位置追踪工具显示的核心关键词排名普遍下滑超过15位,就是一个危险信号。 - “注水”式更新:

为达到某个字数目标,加入大量无实质信息、重复或离题的论述。导致核心信息点被淹没,用户阅读效率下降。 - 结构性混乱:

小标题(H2, H3)没用好,或者更新后逻辑跳跃,段落过长,关键信息没突出(加粗/强调不足),没有清晰的列表(Bullet Points)或表格(Table)来归纳。

如何执行“价值点审计”?

- 并排打开新旧版本:

如果没存档,尝试通过搜索引擎缓存(比如用 cache:yourpage.com/old-page命令)、历史快照工具(如Wayback Machine)或查看站内数据库/文章草稿历史记录找回旧版内容。 - 逐段(甚至逐句)标记对比:

- 核心问题解答保留了吗?

用户最关心的1-3个核心问题,新内容是否都清晰回答且更优? - 关键数据和观点去哪了?

旧内容中独有的数据源、引用的研究报告、具体的工具推荐是否被删除或被无意义的信息替换? - 核心关键词覆盖情况:

旧内容自然提及核心关键词及其近义词的频率?新内容是否明显减少或生硬堆积?用关键词密度工具对比差异(但别迷信数字,自然性优先)。 - “行动价值点”被削弱了吗?

比如操作指南类内容:清晰的步骤被简化成模糊描述?代码片段/截图被移除?旧文中“立即下载”按钮被移除了? - 结构清晰度比较:

旧版是否更易扫读?新版标题是否够清晰?信息组织是否流畅?关键点是否醒目? - 检查内部链接策略变化:

更新时是否移除了指向重要资源的旧内链?或者新增的内链指向了无关或低质量页面?这会削弱页面本身的权威性信号。

新内容真能达到“实用性内容”吗?

可读性与用户体验(UX)退步:

- 语言晦涩难懂:

刻意使用过多行业术语、复杂句式,人为提升阅读门槛。可读性工具检测显示Flesch Reading Ease分数低于60(满分100),表明内容对普通大众可能偏难。 - 关键信息“捉迷藏”:

用户打开页面,第一屏(Above the Fold)看不到核心答案或要点总结,需要滚动很久才能找到。 - 缺乏必要引导:

尤其对于复杂流程,没有清晰的步骤划分、提示框(Callout)或进度提示,让用户感到迷惑。 - 设计或排版分散注意力:

广告插播过多、无关弹窗干扰、字体/颜色对比度不佳导致阅读疲劳。

如何有效进行“可用性压测”?

- 给陌生人(真实小白)看:

找一个不了解你领域的朋友/同事,给他你想优化的核心搜索词(比如“如何给汽车换机油”),然后让他看更新后的页面。让他完成这个任务,并记录: - 他花了多久找到核心答案?

(30秒内是关键)。 - 他能否流畅理解步骤?

哪里卡壳了?(“这里术语我不懂”、“这个地方没说清需要什么工具”、“图片看不清”)。 - 他浏览后的整体感受是什么?

困惑?满意?还是感觉被浪费了时间? - 启用“阅读模式”或打印测试:

浏览器开启阅读模式,或直接打印页面。这能帮你剔除花哨设计,看纯文字内容逻辑是否自洽、信息是否够直接。废话和干扰项在此时会暴露无遗。 - 利用可读性评估工具:

- Hemingway Editor (免费在线):

高亮标记复杂句、被动语态、难懂副词,帮你简化语言,目标建议达到Grade 8(相当于初二)或以下水平更普适。 - Grammarly (免费版):

检查基础语法错误和表达清晰度。 - 优化内容结构:

- 务必使用清晰的H2/H3小标题,准确概括段落主旨。

- 核心结论、关键步骤、重要警告务必加粗。

- 并列信息(如产品特性对比、步骤清单)优先用项目符号列表整理。

- 复杂流程或数据对比务必用表格呈现。

- 在适当位置添加高亮提示框(如“重要提示:…”,“需要准备:…”)。

- 关键位置(如操作步骤前后)配上高清、说明性强的截图或示意图。

发现内容意图不匹配后怎么办?

明确问题根源: 是通过SERP分析、数据对比、用户测试中的哪一个环节确认了问题?是意图理解错误?还是核心价值点丢失?

策略性微调而非盲目回滚: 找到问题点后,在原有更新基础上做有针对性的增补、删减或重组:

- 意图偏差:

补充用户真正关心的内容(比如SERP中“People Also Ask”问题),删除跑题的章节。 - 价值点丢失:

重新加入有独特价值的、被误删的数据源、工具链接或深度见解。 - 相关性稀释:

精简或移除非核心内容,强化围绕核心关键词的论述。 - 结构问题:

重构段落逻辑,运用更清晰的小标题、列表、表格、视觉元素和加粗强调。

小范围测试与迭代: 如果可能,对于重要页面,可以先在测试环境或副本页面上线修改版,观察短期行为数据(GSC点击率、GA停留/跳出)变化。

重新提交索引: 修改完成后,在GSC中“请求重新索引”该URL,通知谷歌内容已优化。

持续关注用户反馈和排名波动: 修改后继续观察GSC搜索词报告和GA用户行为指标,看是否向积极方向发展。

恰好赶上谷歌算法更新

Search Engine Land的行业追踪显示,平均每年谷歌会进行5-7次确认的核心算法更新,外加数百次小规模调整。

如果你更新的时间点“正正好”卡在某个更新窗口(特别是那些持续几周、影响面广的大型核心更新),那排名波动很可能更多是算法整体调整的结果。

近35%经历了超出预期的排名大幅下滑。这很大程度上是因为算法正在重新定义“质量”标准,导致不同网站的优势此消彼长。

确认算法动态

为什么不能只看自己排名下跌?

算法的本质是大洗牌。你在掉,别人(可能是你恨得牙痒痒的竞争对手)可能同时在涨。SEMrush的Sensor工具追踪行业波动数据显示,重大核心更新期间,超过60%的网站排名会出现剧烈波动(波动幅度超过10位)。只盯着自己的一亩三分地,容易误判。 小更新和核心更新的影响天差地别。一个只针对垃圾评论的小修补,和一个重新定义“高质量内容”的核心算法地震,对你的影响完全不同。

如何快速、靠谱地捕捉“风暴”信号?

- 盯紧“信源三角”:

- 谷歌官方“X”(原Twitter)账号 (@GoogleSearchLiaison / @searchlaison):

这是最权威的更新宣布渠道,尤其会提前宣布核心更新。他们通常会说类似:“明天开始发布核心更新,需要几周时间完成”。注意措辞:说“Core Update”还是“Improvements”或者“Spam update”?核心更新影响最大。 - 顶级行业信息站:Search Engine Land

、Search Engine Journal 的新闻频道更新非常快,并且有专门页面持续追踪更新影响(如SEL的 “Google Algorithm Update History”)。他们能快速汇总行业反馈并确认影响范围。 - 值得信赖的SEO KOL:

比如 Barry Schwartz (@rustybrick)、Marie Haynes、Glenn Gabe (@glenngabe) 等经验丰富、言论谨慎的分析师。他们在X平台上的第一手观测和分析往往很有价值,但要交叉印证,避免个别人带节奏。 - 开启“雷达”工具监测行业波动:

- SEMrush Sensor / MozCast / Algoroo / Accuranker Grump:

这些工具能实时(或日更)显示搜索引擎结果页(SERP)的整体“躁动”指数。当 Sensor 或 MozCast 指数飙升至 8/9/10(数值越高越动荡)并持续数天时,极有可能发生重大更新。 - 立刻分析关键竞争对手:

是集体都在跌?集体都在涨?还是只有你和少数几个在掉? 特别留意那些和你更新内容方向相似、域名权重相近的对手。如果他们都掉,那很可能是算法风向变;如果他们很稳甚至涨了,而独你掉,那你的更新问题可能性就更大了。 - Moz调查显示,算法更新期间,约70%的SEO会优先分析竞争对手表现来判断自身问题性质。

列出你的 3-5 个核心竞品。使用排名追踪工具(如SEMrush Position Tracking, Ahrefs Rank Tracker)或者手动搜索几个核心关键词,看他们的排名动向:

这轮算法在“捧”谁、“踩”谁?

谷歌的“哑谜”能破译吗?

谷歌的核心更新公告通常很模糊:“旨在奖励优质内容”,但基本不说具体怎么定义“优质”。不过,还是有蛛丝马迹可循: 上次2023年10月核心更新后,多家分析指出对用户体验(尤其是页面加载速度和交互性 - Core Web Vitals)和深度的、满足搜索意图的内容更为侧重。 之前一些更新则更侧重打击内容农场(Aggregator Sites)、AI生成的低质内容(不满足EEAT)、过度商业化的Affiliate页面(用户价值低)。 - 仔细研读官方公告的字里行间:

即使是简短的几行字,有时也会透露重点,比如“更好地评估网页体验”、“理解内容专业性”等。结合近期谷歌发布的关于搜索质量评估指南的更新方向(公开文档)一起看。 - 行业深度解析报告是金矿:

大型SEO机构(比如Moz, Search Engine Land, Backlinko, Semrush)在更新稳定后会发布详细分析报告。他们分析了成千上万个变动案例后,往往会归纳出共性: - “幸存者”共性分析:

看那些在你这类主题/行业里排名飙升的站点,他们的内容有什么共性?篇幅巨长?引用了更多权威来源?专家背书更突出?页面速度极快?视觉呈现更佳?Sistrix 的研究案例经常能揭示这些“赢家”模式。 - 警惕你的“网站类型”是重灾区:

- YMYL 站点(健康、金钱、法律建议等):

每次更新都是敏感区,因为谷歌对它们的EEAT(经验、专业性、权威性、可信度) 要求极高。Marie Haynes的研究表明,在E-A-T/EEAT相关的核心更新中,YMYL站点受到负面影响的概率是其他站点的2倍以上。 - 电商聚合站 / 联盟营销站:

内容易偏向商业化和浅层,容易被算法认为价值不高。 - 依赖海量低质内容填充或过度优化的站点:

算法主要打击对象。

现在该出手补救,还是趴下“装死”?

大型核心更新期间(几周波动期)—— “静”字诀为主:

- 核心更新是“重新评估”,不是“最终判决”。

谷歌需要时间重新处理所有内容并生成新排名。官方也明确建议,核心更新发布后,通常要等1-2周等更新完全完成、排名初步稳定后,再来判断其影响。 你现在看到的,可能只是混乱期。 - 千万别再“大动作改版”:

在算法波动期频繁修改网站内容或结构,就像在晃动的船上跳舞,摔得更狠。你这次改动的效果都无法判断,怎么确定你新改的就对路?小心越改越糟,让谷歌难以识别你的核心价值。 - 该做什么?专注“监控”和“分析”:

持续关注上面说的行业动态和工具数据(Sensor指数)。 在你的GSC和排名追踪工具里,密切观察核心关键词的排名轨迹变化(尤其更新完成后1-2周内)。是缓慢回升?触底企稳?还是继续跌跌不休? 深入分析GSC的搜索效果报告:哪些关键词在掉?哪些相对稳定甚至微升? 这些词和对应的搜索意图能提供宝贵线索。 记录下所有分析观察到的有价值信息(关于算法可能的倾向)。

更新完成后,如确认排名仍大幅下滑

结合上面的分析(方向+自身数据)定位问题:

如果你的页面在 EEAT(尤其YMYL)上被认为不足:考虑补充作者权威介绍、引用或合作权威机构来源、增加案例研究/真实经验分享、加强引用高质量参考链接。 如果分析指向 用户体验(Core Web Vitals)问题:全力优化页面速度(LCP, FID, CLS)、交互流畅度、移动端适配。 如果 内容意图匹配度被算法重新评估为不足:回到上一篇讲的内容优化原则,根据SERP和用户数据做校准。 如果是 内容深度或独特性欠缺:参考竞品上位内容,补充更有价值的深度分析和独家见解。

做出针对性强、有依据的改进(切忌盲人摸象): 基于定位的问题,做有针对性的内容或技术调整。不是推倒重来。

持续观察改进后的反馈: SEO恢复是场马拉松。改进了特定点后,继续监控排名和流量变化趋势。

更新导致原有链接信号或用户信号受损

例如,外链带来的“投票权重”和用户访问留下的“行为证据”。

想想看:你原来那篇表现好的内容,可能积累了大量反向链接(也叫外链),也获得了不错的用户停留时间和互动数据,但内容更新后,你可能无意中:

- 让那些具有投票权的(外链)“失效”了

—— 比如改了页面地址(URL)但重定向设错了,老链接点进来成死胡同(404错误)。 - 新内容反而让用户不愿停留

—— 更新后页面变复杂,阅读困难,或者导航混乱,用户点进来扫两眼就关掉(跳出率飙升)。Chartbeat的数据就表明,页面加载时间如果从1秒增加到3秒,移动端用户跳出率平均会上升32%。 - 内部“推荐”也断了

—— 更新时删除了网站内部其他重要页面指向这里的链接。

链接权重为什么“消失”了?

问题根源:

- URL变更后301重定向没做、做错或做漏了:

这是最硬伤的一种。AHREFS的研究清晰表明,一个设置正确的301重定向能将旧页面90%以上的链接权重(Link Equity)传递到新页面。 反过来: - 完全没做301:

老链接点过来直接404,用户和爬虫都撞墙。旧页面积累的外链价值瞬间蒸发。 - 301设错了地方:

旧链被定向到无关的新页面(比如首页或类别页),权重没法有效聚焦传递到真正更新后的目标页。 - 链式重定向(Chaining):

/old-page->/temp-page->/new-page。每跳转一次,权重就有损耗(常称为“权重损失”),PassionDigital的案例分析显示,二级重定向会导致传递的权重降低25%-30%左右。 - 漏掉带参数的旧链接:

旧页面可能有 /old-page?source=email这类带参数的变体链接,只给/old-page做了301,那些带参数的链接依然404。 - 重定向设置报错:

服务器配置问题导致本该返回301的请求,报了404(找不到)或500(服务器错误)。 - 新内容变了味,辜负了外链的“推荐信”:

比如以前一篇高质量原创指南被很多权威站引用,但你更新后大幅删减核心干货、增加了大量广告,甚至主题偏离。用户点开那些高质量外链进来一看,内容质量大不如前,失望离开。久而久之,谷歌会认为这些外链指向的内容价值已降低,链接带来的权重加分也就相应减弱。外链工具(如Semrush)有时会标记锚文本与新页面主题相关性降低的警告。

如何诊断“外链信号衰减”?

- GSC效果报告大显身手:

对比更新前后,查看旧URL的展示次数(Impressions)和点击次数(Clicks)变化趋势。理想情况下,更新后(做了301)旧URL的数据应快速下降趋近于零,同时新URL应承接相应的流量趋势。如果旧URL流量骤降但新URL没接住,很大可能就是301没生效或没做好。 留意新页面的排名变化与展示次数/点击率的关系。如果展示次数保持或上升,但点击率(CTR)和排名却持续下降,暗示谷歌认为你的新页面不相关(可能辜负了链接锚文本)。 - 外链工具的“体检报告”:

查找指向旧URL的所有外链(主要是数量)。这些就是你的宝贵资产。 - 抽样点击外链来源:

手动访问5-10个重要的来源页面,点击它们链向你的链接。看是否正确地通过301/308跳转到了新的目标页面?跳转流畅吗?(而不是404或不跳转)。这是最笨但最直接的方法。 查看工具评估的新页面外链概况:检查工具是否已将那些指向旧URL的外链数量或权重部分计入了新页面?(工具会尝试追踪301)。如果数量远少于旧URL,说明重定向设置或追踪可能有问题(或是链式重定向损耗)。 使用Ahrefs(Site Explorer)或Semrush(Backlink Analytics): - 网站日志(Log Files)分析(技术流):

查看谷歌爬虫对旧URL的访问请求记录,看服务器返回的状态码是什么?是 301/308(正确跳转)?还是404/500(错误)?这能精确反映爬虫遇到了什么。

用户行为信号不好

用户用脚投票的真实反馈:

- 跳出率(Bounce Rate)飙升:

在GA4中,跳出率代表用户只看了一个页面、没任何交互就离开你网站的占比(严格说叫“互动率”但问题表现类似)。 - 更新后跳出率若比之前大幅上升(如从40%飙到60%以上),是一个强烈信号:用户觉得点开你的页面后,这不是他们想要的,或者内容太差懒得探索,直接关了。

尤其要关注来自搜索引擎自然流量的跳出率,这代表对搜索意图的直接反馈。 - 停留时间(Engaged Time)骤减:

GA4里记录的是用户真正与页面互动的时间(如滚动、点击)。内容更新后,如果用户平均停留时间从3分钟掉到1分半,说明内容吸引力或可用性变差了。 - 页面点击率(CTR - Click Through Rate)暴跌:

在GSC “效果报告”里查看你的新页面URL在搜索结果中的表现。 相比旧页面在同一排名位置的历史CTR,新页面的CTR是否明显下滑? 如果排名没变甚至微升,但CTR大幅下降(如10%降到5%),这是危险的“脱钩”信号: 你的标题标签(Title Tag)或元描述(Meta Description)没有有效吸引用户点击(说明可能未符合期望),或者用户记住你页面以前的价值,但新版本让他们不愿点进去了! - 更核心的用户体验指标恶化:

- LCP(Largest Contentful Paint - 最大内容渲染时间):

主要图片/文本加载太慢(谷歌建议LCP < 2.5s)。 - FID / INP(Interaction to Next Paint - 交互到下次渲染延迟):

用户点按钮或链接反应迟钝(谷歌建议INP < 200ms)。 - CLS(Cumulative Layout Shift - 累积布局偏移):

用户浏览时页面元素(如图片、广告加载)导致内容突然跳动移位(谷歌建议CLS < 0.1)。 - 更新后如这些指标显著变差,尤其是INP和CLS,会

极大恶化用户体验,直接导致停留时间短、跳出率高。根据谷歌官方统计,CLS较差的页面用户转化率平均下降15%。

如何精准捕捉“用户不满”?

- GA4是核心战场:

Views: 自然搜索流量有明显波动吗? Views per user: 用户只看这一页就跑的比例? Average engagement time: 停留时间是长是短? Event count/ Conversions: 用户互动(点击、滚动等)或转化行为是否减少了?- 页面报告对比:

锁定你的更新页面,在GA4报告里设置时间范围(更新前1个月 vs 更新后1个月),直接对比关键指标: - 探索(Explore)功能深挖:

创建自定义报告,细分流量来源(“Session default channel group” 选为 “Organic Search”),分析特定页面的用户行为。用对比功能一目了然变化。 - Google Search Console 效果报告不可或缺:

紧盯该页面的 CTR 和 平均排名位置 变化(时间范围要够长,至少更新前后各一个月)。 看不同核心搜索查询的表现:是特定的某些查询意图CTR掉得厉害?还是普遍都掉?这能帮你定位是内容偏了哪些点。 - PageSpeed Insights / Web Vitals报告:

定期测试该更新后的页面,跟踪LCP、INP、CLS的分数和诊断意见。明确是不是技术性体验(速度、稳定性)变差赶走了用户。

内部链接结构错误

内部链接的价值:

- 流量引导与爬虫路径:

内部链接是引导用户和谷歌爬虫在站内流动的主要路线图。大量移除指向该页面的重要内链,会让页面变得“孤立”,获得的内部权重支持减少,谷歌对其重要性的判断也会降低。 - 主题相关性传递:

指向一个页面的内部链接锚文本(如“2024年最新谷歌SEO排名因素详解”),是向谷歌传递该页面核心主题的重要信号。更新时若替换了模糊或无关的锚文本(如变成“点这里看详情”),就削弱了这个信号。

更新常见的坑:

- 无意中删除/修改了关键入口链接:

更新网站导航栏(Navigation)、面包屑(Breadcrumb)、首页推广位、相关文章板块(Related Posts)、或正文上下文链接(Contextual Links)时,把原本指向更新页面的链接移除或改掉了。 - 错误的锚文本修改:

为了“多样性”等原因,把原本强相关的锚文本换成无关或弱相关的描述。 - 新版本内容导致相关入口失效:

比如内容重组后,自动生成的相关文章推荐模块不再包含该页面链接。

如何诊断内链损伤?

- 网站爬取(Crawl)工具显身手:

使用 Screaming Frog SEO Spider(免费版即可)或 Sitebulb 爬取你的网站。 - 找到你的更新页面URL:

在爬行结果里定位它。 - 查看“Inlinks”(反链)报告:

这里会清晰列出网站内部有多少个页面链接到了这个页面,以及每个链接的具体来源页URL和使用的锚文本是什么。 - 对比前后(如有存档爬取数据):

对比更新前后该页面的 内链数量 和 主要来源页面(尤其是高权重来源如首页、栏目页)是否减少?核心锚文本是否被弱化? - 手动检查关键节点:

确保首页、主要栏目/分类页、重要的支柱内容页(Pillar Pages)中,依然存在明确、高质量的内链指向你的更新页面。如果首页原来有推荐框现在没了,那影响就很大了。 - 审查新页面内容自身:

新内容是否主动、恰当地链接到网站其他高价值页面?丰富的、相关的内链出链(Outbound Internal Links)也显示其深度和整合度,对排名有益。

谷歌的最终投票权,永远握在搜索用户手里。

一次排名的暂时下滑,其实是算法和用户共同给你的重要反馈。